Kunstmatige intelligentie gaat mensen steeds beter ‘begrijpen’. Hoe werkt dat precies?

,,De kunstmatig intelligente beeldherkenningstechnologie die wij ontwikkelden is daar een goed voorbeeld van. Ons onderbewustzijn reageert in fracties van seconden op impulsen. Dat resulteert soms in blijdschap of woede, maar veel vaker in meer subtiele emotionele reacties. Met het oog zijn die reacties niet of nauwelijks waarneembaar. Maar onze AI-beeldherkenningssoftware registreert die ‘micro-expressies’ wel heel nauwkeurig. Die technologie kan slaperige of agressieve chauffeurs waarschuwen voor hun risicovolle rijgedrag. En helpt NASA om zo gebruiksvriendelijk, efficiënt en dus veilig mogelijke cockpits en dashboards te ontwerpen. Zo kan AI dus echt levens redden.‘’

Veel AI-toepassingen liggen in een grijs ethisch gebied waarin je alle consequenties lastig in één keer kunt overzien

Maar net als elke krachtige technologie kun je daar ook misbruik van maken?

,,Inderdaad. Technologie die de emoties van iemands gezicht kan lezen. Dat maakt het bijvoorbeeld ook makkelijker om iemand te manipuleren. Ik ben ervan overtuigd dat de meeste bedrijven en ontwikkelaars die kant absoluut niet op willen. Onvermijdelijk krijg je echter ook te maken met onbedoelde en onvoorziene toepassingen en consequenties. Wij weigerden bijvoorbeeld vanaf dag één om onze technologie te leveren aan bedrijven of overheden met surveillance doeleinden. Maar dan zijn er opeens ook bedrijven die je technologie willen gebruiken tijdens een sollicitatie- of functioneringsgesprek. Veel AI-toepassingen liggen in een grijs ethisch gebied waarin je alle consequenties lastig in één keer kunt overzien.‘’

Wat adviseer je bedrijven die ongewenste toepassingen van hun AI-technologie willen voorkomen?

,,Je ziet momenteel een enorme toename van het aantal bedrijven dat zelf AI-applicaties ontwikkelt voor gebruik door eigen medewerkers. Eerste cruciale stap is om de opportunity, het beoogde resultaat, heel nauwkeurig te onderzoeken en definiëren. Doe dat met een groep gemotiveerde medewerkers, met een zo breed mogelijke achtergrond. Zo voorkom je wildgroei van toepassingen waarop eigenlijk niemand zit te wachten. Laat deze groep duidelijke richtlijnen opstellen voor het beoogde doel, en de wijze waarop je dat wilt bereiken. Dankzij de diverse achtergrond kan jouw AI-werkgroep veel potentiële issues in een vroeg stadium signaleren.‘’

In aangekochte datasets liggen bijna onvermijdelijk allerlei onzichtbare vooroordelen op de loer

Welke potentiële issues moet je volgens jou in ieder geval goed in de gaten houden?

,,De data waar je jouw AI-model op traint is vaak cruciaal. Met Affectiva verzamelden wij ons benodigde beeldmateriaal van betaalde testpersonen. Die gaven vooraf expliciet toestemming voor nauwkeurig omschreven gebruik van de gemaakte videobeelden. Zo bouwden we in enkele jaren een database op met ruim 5 miljard videofragmenten van meer dan 11 miljoen testpersonen uit 90 landen. We leerden hierdoor onder meer dat getoonde emoties vaak contextgevoelig en cultureel bepaald zijn. Denk bijvoorbeeld aan de polite smile in Japan, of de head bobble in India. Verreweg de meeste ontwikkelaars hebben denk ik niet de luxe om eigen datasets op te bouwen. In aangekochte datasets liggen bijna onvermijdelijk allerlei onzichtbare vooroordelen op de loer.‘’

Affectiva stelde al vroeg een ethische code op. Waarom adviseer jij dat andere bedrijven ook?

,,Ethiek in AI was ooit vooral iets voor academici. Tegenwoordig is het keiharde zakelijke noodzaak om dat goed te regelen. Grote tech-partijen, banken, verzekeraars en andere bedrijven kampen momenteel met serieuze rechtszaken en juridische onderzoeken. Bijvoorbeeld omdat ze data op onjuiste wijze verkregen, of daar dingen mee deden die mogelijk niet door de beugel kunnen. Los van de hoge boetes en schadevergoedingen, kan dat ook leiden tot grote reputatieschade. Omgedraaid werkt dat overigens ook. Bedrijven die bewuster omgaan met dit soort zaken, behalen hogere ESG-scores. En onderzoek door McKinsey wijst uit dat organisaties met een hoge ESG-score beter presteren op de lange termijn, en dat klanten en medewerkers ze positiever beoordelen.‘’

Wie controleert of alles volgens afspraak gaat, en wat doe je als dat niet gebeurt?

Welke elementen moet een goede ethische code of framework in ieder geval bevatten?

,,Je wilt hier in ieder geval je ethische standaarden duidelijk beschrijven. Koppel die aan je technologie: wat is daar allemaal mee mogelijk, wat vinden we acceptabel, wat kan écht niet. Beschrijf dit bijvoorbeeld ook voor verschillende betrokken functies, zoals datawetenschappers of programmeurs. Natuurlijk moet je dan ook duidelijke afspraken maken over regels en toezicht. Wie controleert of alles volgens afspraak gaat, en wat doe je als dat niet gebeurt? Zorg dat iedereen precies begrijpt waarom die afspraken zo belangrijk, wellicht met verplichte trainingen. Zorg ook dat jouw AI-werkgroep de laatste AI-ontwikkelingen nauwlettend volgt, en je framework blijft updaten.‘’

Welke AI-toepassingen vind jij op dit moment interessant als ‘ethische AI-investeerder’?

,,Ik zie bijvoorbeeld veel interessante startups die verschillende soorten AI-agents of companions ontwikkelen. AI-agents kunnen bijvoorbeeld advocaten, artsen of andere professionals helpen bij het uitvoeren van complexe werkzaamheden. AI-companions verzamelen verschillende soorten persoonsgerelateerde data van gebruikers. Zo kunnen ze je motiveren voor een training of belangrijke prestatie, of ondersteunen na een traumatische ervaring of verlies. In het verlengde hiervan verwacht ik ook veel van kunstmatig intelligente privéleraren, zeker in gebieden waar onderwijs niet goed is geregeld. En natuurlijk is het onvermijdelijk dat al die verschillende startups straks ook gebruik gaan maken van een zakelijke mentor, die ze helpt hun oplossing op ethisch verantwoorde wijze uit te rollen.‘’

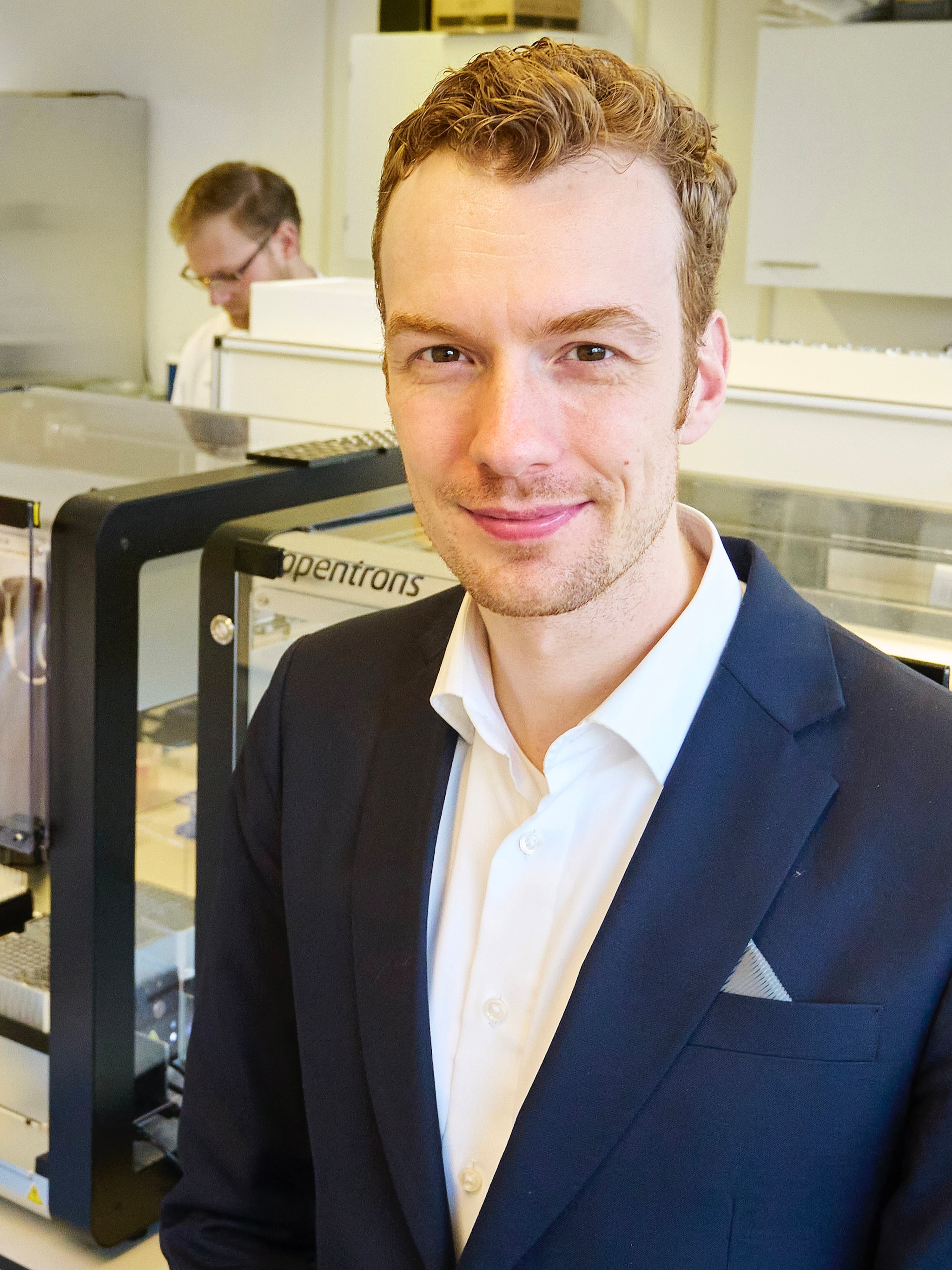

Gabi Zijderveld

Na een succesvolle bliksemcarrière bij IT-reus IBM en liefst 8 succesvolle startups stapte Gabi Zijderveld in 2014 over naar Affectiva. Bij deze 130 medewerkers tellende spin-off van een onderzoeksproject van het gerenommeerde Massachusetts Institute of Technology (MIT) werd zij eindverantwoordelijk voor marketing én productstrategie.

De Emotion AI-technologie van Affectiva (dat in 2021 werd overgenomen door SmartEye) hielp bedrijven als WPP, Coca-Cola en Nike om de (emotionele) reacties op hun reclames te analyseren, maar werd ook toegepast om gedrag van mensen in auto’s te volgen.

In combinatie met de eye tracking technology van SmartEye waarschuwt de AI-technologie BMW- en Polestar chauffeurs voor gevaarlijke situaties. De Amerikaanse ruimtevaartorganisatie NASA gebruikt de technologie voor de optimale inrichting van cockpits, dashboards en andere interfaces.

Met haar onlangs gelanceerde risicokapitaalverstrekker Blue Tulip Ventures ondersteunt Zijderveld AI-startups die mensgerichte en ethisch verantwoorde AI ontwikkelen. Zijderveld mocht onlangs aantreden als jurylid voor de prestigieuze President’s Innovation Challenge van de Harvard Universiteit.

In onze wekelijkse nieuwsbrief vind je het beste van BusinessWise die week en het laatste nieuws over Studio BusinessWise. Abonneer je gratis en blijf altijd op de hoogte!