AI-modellen zoals het Gemini-model van Google zijn gemaakt om onze vragen goed en snel te beantwoorden. Hierbij worden samenvattingen gegenereerd die bovenaan de zoekresultaten verschijnen. Deze zogenaamde AI Overviews baseren zich op een breed scala aan online bronnen en voegen links toe naar originele websites. Maar hoe werkt dit onder de motorkap?

Bekijk ook: Hoe robotisering ons werkleven gaat veranderen: ‘Nederland loopt achter’

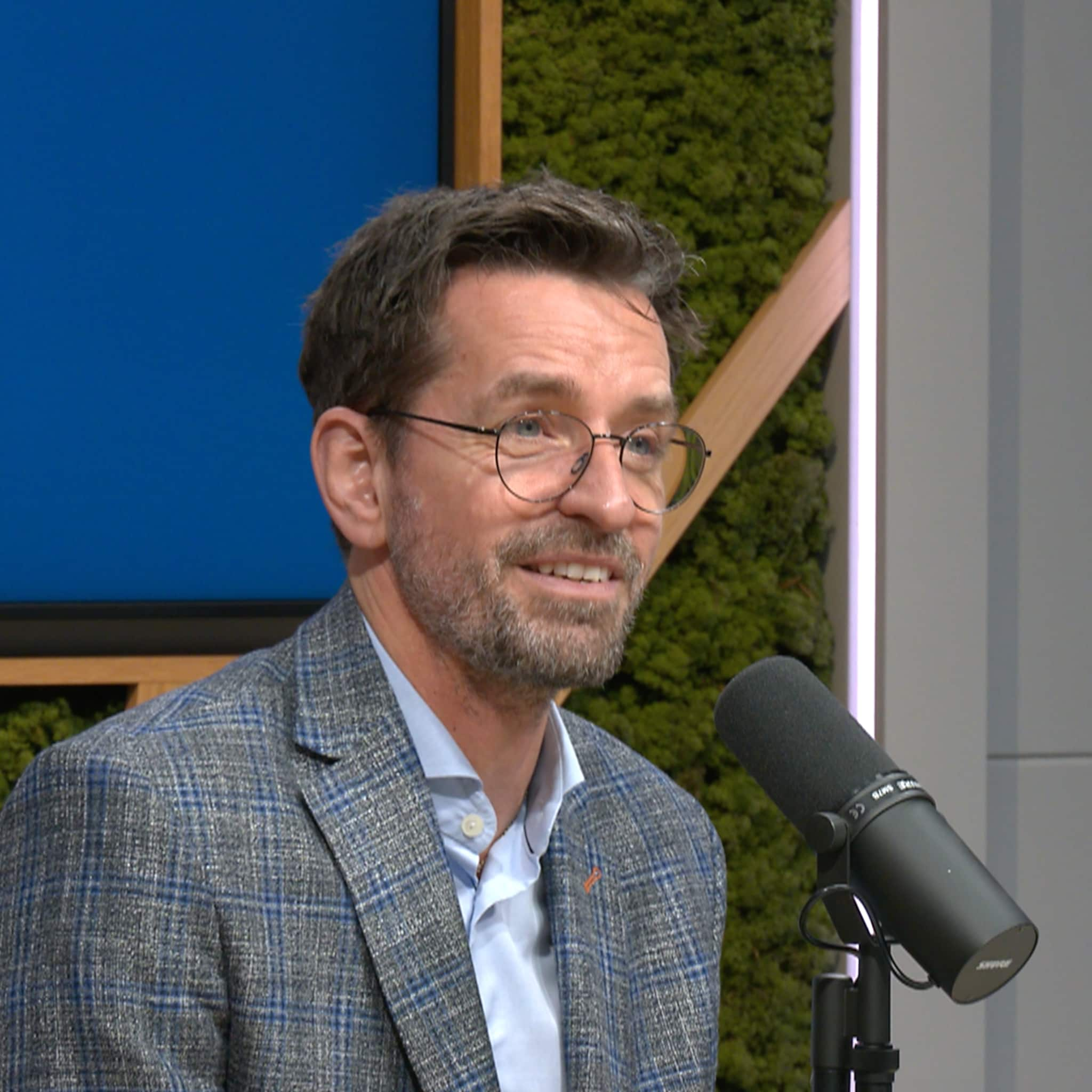

Pim Haselager, hoogleraar Kunstmatige Intelligentie aan de Radboud Universiteit, legt uit dat AI-modellen werken door woordfrequenties te analyseren en patronen in taal te herkennen. „AI werkt fundamenteel anders dan wij. Wij zoeken woorden bij de betekenis die wij willen overbrengen, terwijl een AI puur kijkt naar statistische verbanden tussen woorden.’’ Dit betekent dat AI geen begrip heeft van de betekenis van een zin. Het is, zoals Haselager aangeeft, ‘een geavanceerd woord-voorspel-model’ dat opereert op basis van statistiek en niet op logica of begrip.

BusinessWise Explained is een wekelijkse videoserie van BusinessWise, waarin we in maatschappelijke en economische thema's duiken. Elke woensdag te bekijken op businesswise.nl en vanaf elke vrijdag te zien op ons YouTube-kanaal. Presentatie: Daan Nieber

Wat zijn de risico’s van AI-gegenereerde antwoorden?

Het gebrek aan betekenisgeving brengt risico’s met zich mee. AI-antwoorden lijken overtuigend, maar missen vaak nuance of bevatten zelfs desastreuze fouten. Haselager licht toe: ,,Je zit met een systeem dat wel heel goed kan doen alsof, maar af en toe afgrijselijk door de mand valt.’’ Dit kan problematisch zijn, vooral in gevoelige domeinen zoals medische, juridische of politieke informatie.

Enkele beruchte voorbeelden tonen de ernst van deze fouten. AI van Google suggereerde dat Barack Obama moslim is, wat onjuist is. Andere voorbeelden zijn absurde adviezen, zoals het eten van stenen of het gebruik van lijm in pizzasaus. Bovendien leidde Google’s diversiteitsbeleid tot historische vervalsingen in AI-antwoorden, zoals foutieve weergaven van nazi-soldaten.

Je zit met een systeem dat wel heel goed kan doen alsof, maar af en toe afgrijselijk door de mand valt

Pim Haselager Hoogleraar Kunstmatige Intelligentie

Het snelle gebruik van deze technologieën laat volgens Haselager zien dat bedrijven zoals Google in ‘paniek’ verkeren, omdat hun traditionele verdienmodel, algoritmen die relevante webpagina’s vinden, bedreigd wordt. Met de brede concurrentie vanuit andere AI-systemen probeert Google wanhopig terrein te behouden.

Lees ook: 'Soms vergeet je bijna dat je met AI praat': Philips betrekt AI-persona's in marketing

Hoe komt AI aan trainingsdata en wat zijn de gevolgen?

Een andere cruciale uitdaging bij AI-taalmodellen is hoe ze worden getraind. Deze modellen baseren zich op enorme hoeveelheden online data, zoals nieuwsartikelen, boeken en websites. Alleen het internet raakt steeds meer vervuild met door AI gegenereerde teksten. Studies tonen aan dat 30 tot 40 procent van de inhoud van actieve webpagina’s inmiddels door AI is gemaakt.

Je wordt alleen maar slechter in een bepaalde richting die je toch al opging

Pim Haselager

Als AI-modellen op hun eigen gemaakte content blijven trainen, ontstaat er een risico van ‘zelfvergiftiging’. Dit houdt in dat de modellen steeds minder divers en kwalitatief hoogstaande antwoorden geven omdat ze zichzelf bevestigen en geen nieuwe patronen leren. Haselager licht toe: „Je wordt alleen maar slechter in een bepaalde richting die je toch al opging.’’

Ironisch genoeg maakt deze situatie menselijk gegenereerde data waardevoller. Bedrijven zoals Google moeten nu betalen aan nieuwsagentschappen en kranten om verse, authentieke data te verkrijgen en de groeiende zelf-vervuiling van AI-systemen tegen te gaan.

Lees ook: ‘De AI-transitie begint bij het middle management’

Hoe maakt AI antwoorden aantrekkelijk voor gebruikers?

AI-systemen zoals ChatGPT staan erom bekend dat ze overtuigend en onaantastbaar overkomen. Dit komt deels door technieken zoals microtargeting. Met behulp van persoonlijke data, zoals locatie en zoekgeschiedenis, kan AI antwoorden afstemmen op individuele gebruikers. Dit maakt de respons niet alleen aantrekkelijker, maar vergroot ook de kans dat een gebruiker het voor waar aanneemt.

Een zorgwekkende trend is dat AI veel mensen minder kritisch maakt. Volgens studies van MIT en Microsoft leiden taalmodellen ertoe dat we minder aandacht besteden aan het formuleren en analyseren van onze eigen gedachten. Pim Haselager wijst op het belang van kritisch denken: ,,Het proces om woorden bij je ideeën te zoeken is leerzaam. Het ervaren dat woorden tekortschieten, helpt je begrijpen wat je eigenlijk bedoelt.’’

Lees ook: Is Nederland nog steeds een belastingparadijs?

AI als tool, niet als waarheid

Hoewel AI ongetwijfeld handig is voor het beantwoorden van simpele vragen, is het belangrijk te onthouden dat kunstmatige intelligentie geen onderscheid maakt tussen feit en fictie. Het voelt niet aan of iets logisch is, noch kan het ethisch redeneren. Daarom is het essentieel om AI-antwoorden te verifiëren, bronnen te controleren, en kritisch te blijven.

Of zoals Haselager het verwoordt bij het gebruik van Google’s AI Overviews: ,,Het kan natuurlijk nooit kwaad om toch even door te scrollen, wat bronnen aan te klikken en zélf op zoek te gaan naar het antwoord.’’

Bekijk ook: Hoe Europa kan aanhaken in de AI-strijd tussen Amerika en China

Bekijk ook: Personeelsbeleid op de schop? 'Nieuwe menselijke skills bloeien op dankzij AI-ondersteuning'

Ontvang elke week het beste van BusinessWise in je mailbox. Schrijf je hier nu gratis in: